硅谷人工智能

挖掘潜在风险:人工智能公司的披露问题

简介:最近硅谷出现了一位吹哨人,他指出人工智能公司不太可能主动披露技术风险信息。这引发了人们对于人工智能技术在透明度和风险评估方面的担忧。本文将讨论人工智能公司披露风险信息的挑战、复杂性,并提出相应的解决方案和指导建议。

人工智能已成为当今科技领域的热门话题,其在各个行业的广泛应用也引起了公众的关注。然而,正如吹哨人所指出的那样,人工智能公司自觉披露技术风险信息的情况并不乐观。这一情况引发了对人工智能透明度和风险评估的担忧。

一方面,人工智能公司之所以难以自觉披露风险信息,一部分原因是技术的复杂性和不确定性。人工智能往往基于大量的数据和复杂的算法,机器学习的黑盒特性使得其决策过程难以解释和理解。在面对未知的技术风险时,公司很难准确评估和披露。

另一方面,人工智能公司也面临商业竞争和保密的压力。在高度竞争的市场中,公司往往会尝试保护自己的技术和商业优势。披露风险可能会让公司面临竞争的挑战或法律责任。因此,公司可能更倾向于保持沉默,而不愿意公开风险信息。

面对这些挑战,我们需要一些解决方案来推动人工智能公司更加自觉地披露风险信息。以下是一些建议:

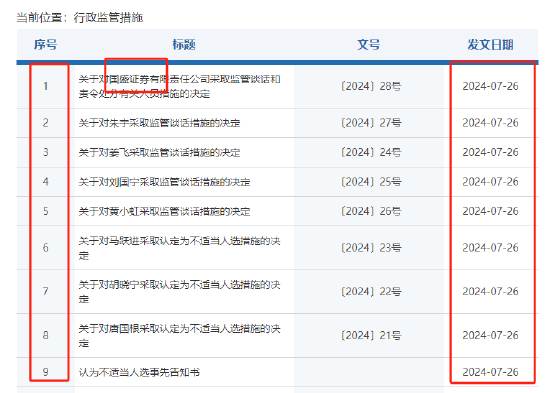

1. 加强监管和法规:政府和监管机构可以制定更严格的法规和标准,要求人工智能公司披露技术风险。这将提高透明度,减少信息不对称,并鼓励公司自觉披露。

2. 建立行业标准:行业组织和标准机构可以联合制定人工智能行业的披露标准。这些标准可以规范披露的内容和方式,降低公司的风险,并为公众提供更多的可靠信息。

3. 强调伦理和透明度:人工智能公司应该将伦理和透明度作为核心价值观。公司应该积极主动地与公众分享他们的技术和研究成果,并解释其对社会的影响和潜在风险。

4. 促进合作和知识共享:人工智能公司可以加强合作,共享技术研究和风险评估的知识。这将促进跨公司和学术界的交流,使整个行业能够更好地认识到技术风险,并共同解决这些问题。

人工智能公司自觉披露技术风险信息是一个复杂的问题,涉及技术、商业和伦理等多个方面。在推动人工智能技术的发展和应用的我们需要加强监管、建立行业标准,强调伦理和透明度,并促进合作和知识共享。只有这样,我们才能更好地了解和管理人工智能的潜在风险,保障公众的权益和安全。